如今,隨著機架功耗飆升至前所未有的水平,數據中心領域正在發生巨大變革。在計算密集型人工智能(AI)和高性能計算(HPC)應用的推動下,數據中心已迅速從只需采用風冷策略為10至20千瓦的機架散熱,轉變成為配備英偉達Grace Blackwell超級芯片的120千瓦機架散熱——而這僅針對單個機柜的散熱需求!

傳統風冷技術根本無法有效應對如此高的散熱需求,這為新型液冷技術的發展鋪平了道路。當前主流液冷方案主要分為兩大類別:"直觸芯片式"與"浸沒式"。與傳統氣體冷卻方式不同,這些技術通過水或絕緣液體等液態介質來為設備散熱。

隨著行業向可持續AI未來邁進,為滿足持續增長的計算需求而建立的AI工廠正在興起,液冷技術必將成為數據中心應對散熱管理、能耗控制及空間利用等核心挑戰的關鍵賦能技術。事實上,面對新一代GPU高達1200瓦的功耗水平,液冷技術已從“錦上添花”演變為“絕對剛需”。隨著全球對這項技術需求的激增,Mordor Intelligence等機構預測,到2029年,液冷技術市場的規模將達到148億美元。

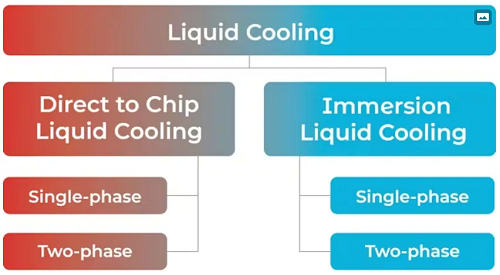

那浸沒式與直觸芯片式液冷的技術差異有哪些呢?兩種方案均包含單相與雙相兩種技術路線。本文將從可持續性、能耗表現、易用性、風險控制、擴展能力及成本效益(見圖1)等維度系統分析各方案的優劣勢。

圖1:市場細分顯示直觸芯片式與浸沒式液冷方案下的技術變體。

沉浸式液冷技術:全浸沒組件

浸沒式液冷技術將服務器及其他電子組件完全浸沒于絕緣液體中。設備運行時產生的熱量被傳導至周圍冷卻介質。受熱后的冷卻介質上升至液面,隨后被輸送至冷卻系統進行熱量消散,最后回流至設備所在的初始儲液槽中。

沉浸式液冷有兩種類型:

單相浸沒

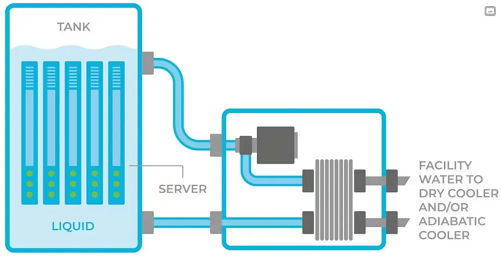

該技術方案將所有服務器及其他IT設備浸沒于絕緣液體中。當CPU或GPU溫度升高時,流體吸收其產生的熱量。隨后,這些受熱流體被泵送至熱交換單元進行冷卻,冷卻后的流體重新回流至設備所在的儲液槽中(見圖2)。

圖2:單相浸沒式液冷:設備完全浸沒于絕緣液體中。

優點:

能完全吸收服務器產生的熱量,這意味著服務器(GPU、CPU、內存模塊等)散發的所有熱量都能被收集并冷卻;

采用絕緣液體,確保組件與服務器不會發生短路。

缺點:

熱設計功耗(TDP)受限。當GPU的TDP超過700瓦時,單相浸沒式方案難以提供有效散熱;

需要對數據中心基礎設施改造進行大量投資,因需配置大型重型儲液槽來容納設備。該技術更適用于新建數據中心,或具備充足空間且可進行大規模改造的現有設施,同時需確保建筑結構能夠承載額外重量;

浸沒槽內所有設備(包括服務器、連接器、印刷電路板等)必須與絕緣液體兼容,以避免被液體損壞。這通常需要選用專用設備或對服務器進行改造;

由于服務器部分組件(如光纖連接器)無法在浸沒環境下正常工作,需對服務器進行機械重構;

所用含碳氫化合物的流體具有易燃易爆特性,若數據中心發生火災可能導致災難性后果;

服務器維護困難,任何維護操作均需使用起重機將單個服務器吊出儲液槽,并需等待30分鐘滴液時間后方可開始維修;

流體若受到污染(例如混入水),需排空并清洗儲液槽,可能導致長達一整天的停機時間。

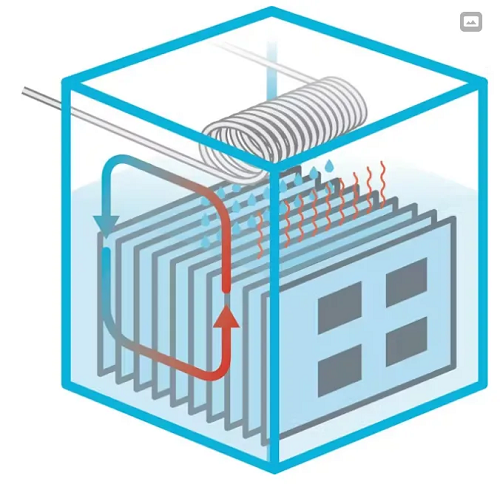

雙相浸沒

與單相浸沒類似,該技術方案同樣將服務器及IT設備完全浸沒于絕緣液體中。然而,當電路板上的組件溫度升高時,會使流體沸騰產生蒸汽,這些蒸汽從液體中上升至儲液槽頂部。儲液槽頂部設有冷卻水管網絡,當槽內蒸汽接觸冷卻管時發生冷凝,重新液化為液體滴回槽內;同時,冷卻管中的水溫升高,通過熱水將熱量帶出設備,最終從數據中心排出(見圖3)。

圖3:兩相浸沒:服務器設備浸沒于絕緣液體中。

優點:

能完全吸收服務器產生的熱量,這意味著服務器(GPU、CPU、內存模塊等)散發的所有熱量都能被收集并冷卻;

能夠支持非常高的熱設計功耗(TDP);

使用絕緣液體,確保組件與服務器不會發生短路。

缺點:

浸沒槽內所有設備(包括服務器、連接器、印刷電路板等)必須與絕緣液體兼容,以避免被液體損壞。這通常需要選用專用設備或對服務器進行改造;

作為流體沸騰過程的一部分,強烈的氣蝕現象會損壞信息技術部件、印刷電路板及焊接點;

需要對數據中心基礎設施改造進行大量投資,因需配置大型重型儲液槽來容納設備,并加強建筑結構以承載額外重量;

由于液槽和浸沒設備的重量,維護工作通常需要使用起重機,導致長時間停機。

每次開槽維護時,含全氟烷基物質(PFAS)的蒸汽會釋放到環境中,每年造成約10%的液體損耗(數百升),并向大氣中釋放大量PFAS蒸汽。

直觸芯片式液冷技術原理

與將整個服務器及其他IT設備浸沒于液體中的浸沒式液冷不同,直觸芯片式液冷將冷卻液輸送至直接放置在高熱流密度組件(如CPU和GPU)上方的冷板中。冷卻液通過冷板吸收組件產生的熱量,并始終封閉在冷板內部,不會直接接觸芯片或服務器設備。

直觸芯片式液冷被廣泛認為比其他冷卻方式更快、更高效,因為它能夠精準針對主要發熱區域進行散熱。事實上,在近期Omdia分析師峰會上,他們的分析師指出:“當機柜功率超過50千瓦時,直觸芯片式技術將占據主導地位。”

由于冷板主要安裝在高熱流密度組件上,因此服務器仍需配備風扇以排出低熱流密度組件產生的多余熱量。

直觸芯片式液冷也有兩種類型:

單相直觸芯片式液冷

該液冷方法使用水作為冷板中的冷卻介質。水始終保持液態,其散熱能力取決于水流量——熱量越高,所需的水流量越大。

優點:

憑借高流量的冷水,它能夠為高熱設計功耗(TDP)組件散熱;

數據中心基礎設施和服務器架構與風冷方案高度兼容,僅需微小改動即可集成冷板冷卻系統。

缺點:

由于使用普通水而非絕緣液體,一旦發生泄漏,不僅可能損毀價值30萬美元的服務器,還會引發腐蝕、發霉、殘留物沉積、生物污染及其他環境問題;

隨著水流速和壓力提升,需要采用防泄漏性能更強的管路組件。

同時需配備更大功率的水泵來維持系統持續水循環。

兩相直觸芯片式液冷

與使用水的直觸芯片式液冷不同,兩相方案采用對IT設備100%安全的絕緣冷卻液。GPU和CPU產生的熱量在低溫下使絕緣冷卻液沸騰,利用高效的相變物理現象吸收熱量,從而使芯片保持恒溫。其原理類似于沸水使鍋底維持在100°C,只是工作溫度更低。

絕緣液體從液態變為氣態,然后再回到液態的過程是在一個完全封閉的循環系統中完成的。即使熱量增加三倍(比如GPU和CPU溫度更高),冷板內的液體也不會超過沸點。因此,這種技術具有高度可擴展性,能夠適應未來更高功率芯片的冷卻需求。

這與單相直觸芯片冷卻方式形成鮮明對比,后者依賴于大量水的流動來冷卻芯片。舉例來說,一個使用兩相直觸芯片冷卻技術的100千瓦機架,所需的絕緣液體不到4加侖,而浸沒式冷卻每機架則需要超過100加侖的冷卻液。

優點:

無水直接芯片液冷:采用對IT設備100%安全的絕緣液體,即使發生泄漏(極不可能),也不會損壞服務器;

提升計算密度:支持單機架功率超過150千瓦;

面向未來:可支持單芯片功率高達2500瓦甚至更高;

與風冷相比,可節省高達80%的功耗;

由于液體保持恒溫,服務器產生的熱量可回收再利用,例如為鄰近辦公室、數據中心其他區域,甚至附近的學校和辦公樓供暖;

幾乎無需對數據中心基礎設施進行改造,前期投資成本低,安裝過程簡單;

維護需求低:絕緣液體無需更換,且與浸沒式液冷不同,在服務器和機架維護期間,這種冷卻液不會釋放到大氣中。所用液體的臭氧消耗潛能(ODP)為0,全球變暖能值(GWP)極低;

即使下一代GPU的熱量增加,仍可維持1U服務器規格。

缺點:

液冷僅用于CPU/GPU散熱,其他組件(如內存、I/O等)仍需風冷。

條條大路通液冷

人工智能的未來發展很大程度上取決于數據中心擴容的能力,這將使數據中心內部的熱量達到前所未有的水平。正如本文所述,目前有多種液冷技術可用于散熱,但每種技術都有其優缺點。

數據中心和超大規模數據中心運營商需要根據成本、功耗、易用性、可擴展性和可持續性等因素,選擇最適合自身的解決方案。只有這樣,行業才能實現真正的人工智能可持續發展。